Appleは9月3日、8月に発表していた「児童の性的虐待対策」を延期すると発表しました。12歳以下のユーザーがメッセージアプリで児童性的虐待コンテンツ(CSAM)を送信すると警告する機能や、写真に保存されているCSAMを検出し当局に通報する機能などが追加される予定でした。

児童性的虐待コンテンツを検出する機能、提供延期

Appleは今年8月、「子どもたちへの保護の拡大(Expanded Protections for Children)」を、iOS 15、iPadOS 15、watchOS 8、macOSMontereyのアップデートとして今年後半にリリースすると発表。しかし、さまざまな方面からの批判や意見をうけ、9月3日、計画を延期すると発表しました。

この新機能では大きく3つが提供される予定でした。

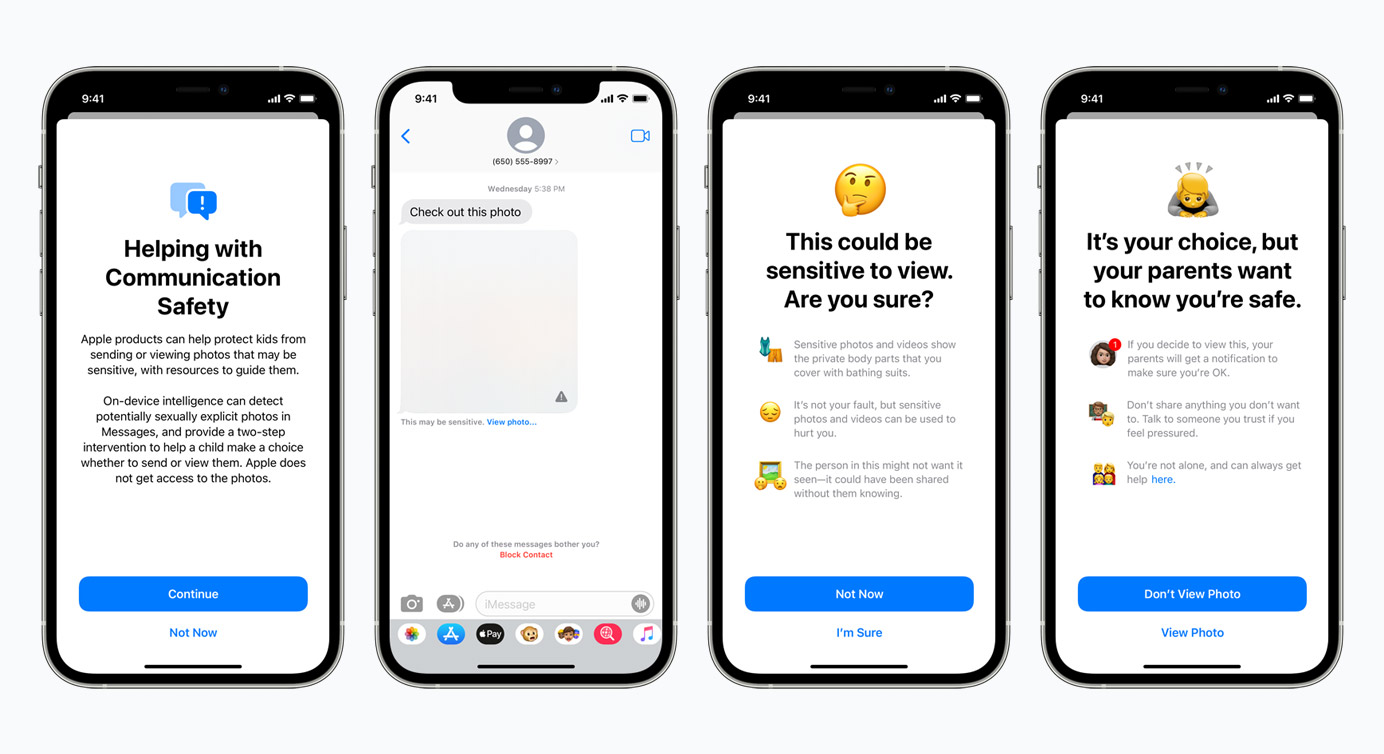

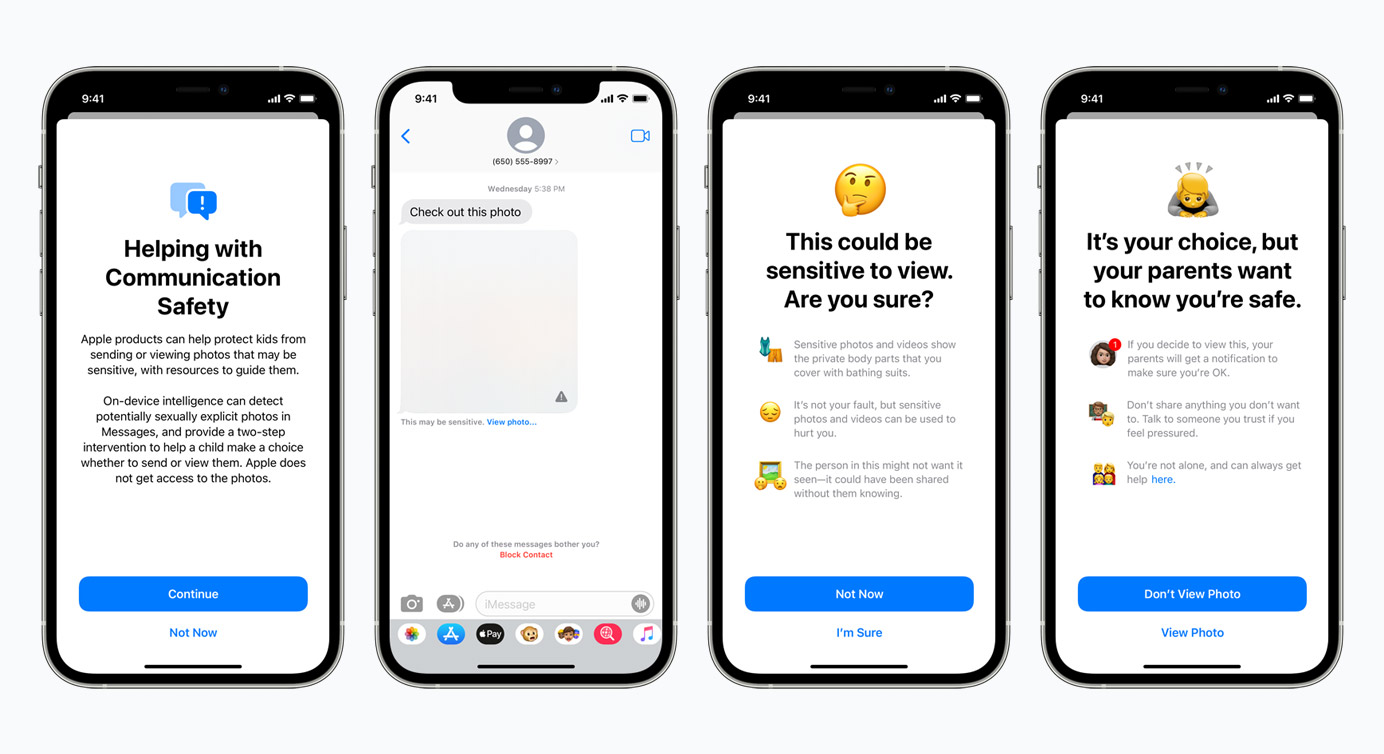

- 子ども(12歳以下のユーザー)がメッセージアプリで児童性的虐待コンテンツ(Child Sexual Abuse Material、以下CSAM)を送受信しようとすると本人と保護者に警告する機能

- 写真アプリ内のコンテンツがiCloudにアップロードされる際、CSAMを検知して当局に報告する機能

- Siriやk年作でCSAM関連の検索をすると警告する機能

Appleが画像をスキャンして調べるわけではなく、全米行方不明・被搾取児童センター(NCMEC)などによって提供されるCSAM画像のハッシュデータベースを使用します。

メッセージアプリの送受信検知では、デバイス内で機械学習が使われるため、Appleはデータにアクセスしません。またiCloudでの検知でも同様で、アップロード時にハッシュの一致を調べる。ハッシュと一致するコンテンツが一定数確認されると、Appleが確認しアカウントが無効化されNCMECに報告されます。

あくまでCSAM画像のデータベースにある既知のCSAMコンテンツと、端末内のデータが一致するコンテンツが存在しないか、という仕組み。

例えば「自分の子どもとお風呂に入っている写真」などは、CSAMのデータベースには存在しないため、この機能で検出されることはありません。

問題とされているのは、AppleがNeuralHashと呼ぶこの技術が誤用される可能性などです。EFF(Electronic Frontier Foundation)は、罪のない人が巻き込まれたりする可能性などを指摘し。また異なる画像であっても同じハッシュが生成されてしまう「ハッシュの衝突」も確認されています。

Microsoftの「PhotoDNA」など、すでにCSAM検知システムは各サービスで採用されている

CSAM検知の対策はすでにMicrosoftなどが先行していて、むしろAppleの対応は遅すぎるという問題点があります。

このCSAMのデータベースを利用してハッシュが一致するか確認する仕組みとして、Microsoftは2009年から「PhotoDNA」を開発。現在はMicrosoftのサービスであるBingやOneDriveに採用されていますし、GoogleやFacebook、Twitter、Adobe、Discord、Redditなどでも画像の内容を確認するシステムが導入されています。

すでに各サービスで導入されていますが、Appleの場合は「デバイス内のコンテンツ」が検知対象になっていることが大きな違い。ジョンズ・ホプキンス大学のセキュリティ研究者であるMatthew D. Green氏は、このシステムが権力と結びついた時、すべてのユーザーの端末内を検知することができるようになってしまうと指摘しています。